Testbericht zur ATI RADEON VE Grafikkarte. Geheimmaterialien von ATi. Test der neuen Grafikkarten der Radeon X800-Serie Teures AMD-Flaggschiff

Auf einem 128-Bit-Bus. Es ist einfach peinlich, sich an die „Geschwindigkeit“ zu erinnern, die sie an den Tag legen. Daher könnten für ATI schwierige Zeiten im Preissegment von 150 bis 250 US-Dollar auf dem AGP-Markt kommen, insbesondere wenn NVIDIA die GeForce 6600 tatsächlich in einer AGP-Variante herausbringt, was sehr wahrscheinlich ist.

An dieser Stelle verlassen wir Prognosen und Annahmen und konzentrieren uns auf das neue Produkt des kanadischen Unternehmens, um vorübergehend vom AGP-Markt zu abstrahieren und die RADEON X700XT mit der GeForce 6600GT zu vergleichen.

Offizielle Spezifikationen von RADEON X700XT/PRO (RV410)

- Chip-Codename RV410

- 110-nm-Technologie (TMSC, Low-k, Kupferverbindungen)

- 120 Millionen Transistoren

- FC-Gehäuse (invertierter Chip, ohne Metallabdeckung)

- 128-Bit-Speicherschnittstelle (Dual-Channel-Controller) (!)

- Bis zu 256 Megabyte DDR/GDDR-2/GDDR-3-Speicher

- Integrierte PCI-Express 16x-Busschnittstelle (vielleicht wird ATI in Zukunft seine eigene PCI-Express->AGP 8x-Brücke verwenden, um AGP-Karten herzustellen)

- 8 Pixelprozessoren, jeweils eine Textureinheit

- Berechnen, mischen und zeichnen Sie bis zu 8 volle Pixel (Farbe, Tiefe, Musterpuffer) pro Taktzyklus auf

- Berechnen Sie bis zu 16 Tiefenwerte pro Taktzyklus im MSAA-Modus (d. h. MSAA 2x ohne Straftaktzyklen)

- Unterstützung für „Zwei-Wege“-Vorlagenpuffer;

- MSAA 2x/4x/6x, mit flexibel programmierbaren Probenahmemustern. Bildpuffer- und Tiefenpufferkomprimierung in MSAA-Modi. Möglichkeit, MSAA-Muster von Frame zu Frame zu ändern (Temporal AA);

- Anisotrope Filterung bis einschließlich 16x

- 6 Vertex-Prozessoren (!)

- Alles, was Sie zur Unterstützung von Pixel- und Vertex-Shadern Version 2.0 benötigen

- Zusätzliche Funktionen von Pixel-Shadern basierend auf der erweiterten Version 2.0 – die sogenannten. 2.0.b

- Klein Zusatzfunktionen Vertex-Shader, jenseits von Basis 2.0

- Eine neue Texturkomprimierungstechnik, die für die Komprimierung von Zweikomponenten-Normalkarten optimiert ist (sog. 3Dc, Komprimierungsverhältnis 4:1).

- Unterstützt das Rendern in Floating-Format-Puffer mit FP16- und FP32-Präzision pro Komponente.

- 3D- und FP-Texturformate (Floating) werden unterstützt

- 2 RAMDAC 400 MHz

- 2 DVI-Schnittstellen

- TV-Out- und TV-In-Schnittstelle (letzteres erfordert einen Schnittstellenchip)

- Möglichkeit der programmierbaren Videoverarbeitung – Pixelprozessoren werden zur Verarbeitung des Videostreams eingesetzt (Komprimierung, Dekomprimierung und Nachbearbeitungsaufgaben)

- 2D-Beschleuniger mit Unterstützung für alle GDI+-Funktionen

Technische Daten der RADEON X700XT-Referenzkarte

- Kernfrequenz 475 MHz

- Effektive Speicherfrequenz 1,05 GHz (2*525 MHz)

- Speicherbus 128 Bit

- Speichertyp GDDR3

- Speicherkapazität 128 (oder 256) Megabyte

- Speicherbandbreite 16,8 Gigabyte pro Sekunde.

- Die theoretische Füllrate beträgt 3,8 Gigapixel pro Sekunde.

- Die theoretische Textur-Sampling-Geschwindigkeit beträgt 3,8 Gigatexel pro Sekunde.

- Ein VGA- (D-Sub) und ein DVI-I-Anschluss

- TV-Ausgang

- Verbraucht weniger als 70 Watt Energie (d. h. auf der PCI-Express-Karte gibt es einen Anschluss für zusätzliches Essen nicht erforderlich, eine Stromquelle mit einer Gesamtleistung von 300 Watt oder mehr wird empfohlen)

Liste der derzeit auf RV410 basierenden Karten:

- RADEON

- RADEON 6600;

- RADEON nach unten vorheriger X600XT;

Wie wir sehen, gibt es keine besonderen architektonischen Unterschiede zum R420, was jedoch nicht verwunderlich ist – der RV410 ist eine skalierte Lösung (durch Reduzierung der Anzahl der Pixelprozessoren und Speichercontrollerkanäle) auf Basis der R420-Architektur. Die Situation ist die gleiche wie beim Paar NV40/NV43. Darüber hinaus sind, wie bereits erwähnt, die Architekturprinzipien beider Konkurrenten in dieser Generation äußerst ähnlich. Die Unterschiede zwischen RV410 und R420 sind quantitativer Natur (im Diagramm fett dargestellt) und nicht qualitativer Natur – aus architektonischer Sicht ist der Chip nahezu unverändert geblieben.

Es gibt also 6 (so wie es war – was möglicherweise eine angenehme Überraschung für Dreieck-hungrige DCC-Anwendungen ist) Vertex-Prozessoren und zwei (es waren vier) unabhängige Pixelprozessoren, von denen jeder mit einem Quad (2x2 Pixelfragment) arbeitet. Wie beim NV43 ist PCI Express eine native (d. h. auf dem Chip implementierte) Busschnittstelle, und AGP 8x-Karten (falls dies der Fall ist) enthalten eine zusätzliche PIC-E -> AGP-Brücke (siehe Abbildung). die von ATI entwickelt und produziert werden müssen.

Darüber hinaus stellen wir einen sehr wichtigen Grenzpunkt fest – einen Dual-Channel-Controller und einen 128-Bit-Speicherbus – wie im Fall des NV43, den wir weiter im Detail diskutieren und untersuchen werden.

Die Architektur der Vertex- und Pixelprozessoren sowie des Videoprozessors blieb gleich – diese Elemente wurden in unserem Test der RADEON X800 XT ausführlich beschrieben. Lassen Sie uns nun über mögliche taktische Überlegungen sprechen:

Überlegungen darüber, was gekürzt wurde und warum

Im Allgemeinen erhalten wir derzeit die folgende Reihe von Lösungen, die auf den Architekturen NV4X und R4XX basieren:

Pixel/ | Speicherstreifen | Füllrate | Kernfrequenz |

|||

256 (4 × 64) | ||||||

256 (4 × 64) | ||||||

256 (4 × 64) | ||||||

256 (4x64) | ||||||

128 (2x64) | ||||||

128 (2x64) | ||||||

256 (4 × 64) | ||||||

256 (4 × 64) | ||||||

256 (4 × 64) | ||||||

128 (256 als Option) (2x64) | ||||||

256 (128 optional) (2x64) | ||||||

128 (256 als Option) (2x64) | ||||||

Basierend auf der Architektur der vorherigen Generation |

||||||

Stimmt es nicht, dass das Bild sehr ähnlich ist? Wir können also vorhersagen, dass der Schwachpunkt der X700-Familie, wie auch im Fall des 6600, hohe Auflösungen und Modi mit Vollbild-Anti-Aliasing, insbesondere bei einfachen Anwendungen, sein werden, während die Stärke Programme mit langen Programmen sein werden Shader und anisotrope Filterung ohne (oder, für ATI, vielleicht mit) MSAA. Als nächstes werden wir diese Annahme mit Spiel- und synthetischen Tests überprüfen.

Wie gerechtfertigt der Umstieg auf einen 128-Bit-Speicherbus war, lässt sich heute nur noch schwer beurteilen – einerseits werden dadurch die Kosten für den Chipkörper gesenkt und die Anzahl defekter Chips verringert, andererseits der Preisunterschied Der Preis einer Leiterplatte für 256 Bit und 128 Bit ist nicht groß und wird durch den Preisunterschied zwischen normalem DDR- und immer noch teurem Hochgeschwindigkeits-GDDR3-Speicher mehr als ausgeglichen. Wahrscheinlich wäre aus Sicht der Kartenhersteller eine Lösung mit einem 256-Bit-Bus bequemer, zumindest wenn sie die Möglichkeit hätten zu wählen, aber aus Sicht von NVIDIA und ATI, die oft Chips produzieren Verkaufen Sie Speicher mit ihnen, 128-Bit ist eine profitablere Lösung, die in GDDR3 enthalten ist. Ein weiterer Aspekt ist, wie sich dies auf die Geschwindigkeit auswirkt – schließlich besteht eine potenzielle Einschränkung der hervorragenden Fähigkeiten des Chips (8 Pipelines, 475 MHz Kernfrequenz) aufgrund der deutlich reduzierten Speicherbandbreite.

Beachten Sie, dass NVIDIA das Ultra-Suffix vorerst reserviert hat – angesichts des großen Übertaktungspotenzials der 110-nm-Technologie können wir mit dem Erscheinen einer Karte mit einer Kernfrequenz von etwa 550 oder sogar 600 MHz und 1100 oder sogar 1200 Speicher (in Zukunft) rechnen ) und der Name 6600 Ultra. Aber wie hoch wird der Preis sein?

Die Vertex- und Pixel-Prozessoren des RV410 blieben offenbar unverändert, die internen Caches konnten jedoch zumindest im Verhältnis zur Anzahl der Pipelines reduziert werden. Die Anzahl der Transistoren gibt jedoch keinen großen Anlass zur Sorge – angesichts der nicht so großen Größe der Caches wäre es sinnvoller, diese zu belassen (wie beim NV43, um so den spürbaren Speichermangel auszugleichen). Alle Technologien zur Speicherbandbreiteneinsparung wurden vollständig beibehalten – Tiefenpufferkomprimierung und Bildpuffer, früheres Clipping mit hierarchischem Tiefenpuffer auf dem Chip usw.

Interessanterweise stimmen die Pixelpipelines des RV410 in dieser Hinsicht im Gegensatz zum NV43, der, wie bereits erwähnt, Blending durchführen und nicht mehr als 4 resultierende Pixel pro Taktzyklus aufzeichnen kann, vollständig mit dem R420 überein. Dementsprechend erhält der RV410 bei einfachen Shadern mit einer Textur einen fast doppelten Vorteil in der Shading-Geschwindigkeit. Im Gegensatz zu NVIDIA, das über eine ziemlich große Auswahl an ALU-Transistoren verfügt, die Nachbearbeitung, Verifizierung, Z-Generierung und Mischung von Pixeln in einem Floating-Format durchführen, verfügt der RV410 über bescheidenere Kombinatoren, weshalb deren Anzahl nicht so stark reduziert wurde. In den meisten PRAKTISCHEN Fällen erlaubt die reduzierte Speicherbandbreite jedoch keine Aufzeichnung von 3,8 vollen Gigapixeln pro Sekunde, aber bei synthetischen Tests kann der Unterschied zwischen RV410 und NV43 bei einer Textur sehr deutlich werden.

Nicht weniger interessant ist die Entscheidung, alle 6 Scheitelpunktblöcke zu belassen. Einerseits ist dies ein Argument im DCC-Bereich, andererseits wissen wir, dass es dort vor allem auf Treiber und vor allem auf OpenGL ankommt – traditionell Stärken NVIDIA. Darüber hinaus gibt es dort Floating Blending und Shader 3.0 zu schätzen – genau das, was der neuesten Generation von ATI fehlt. Daher erscheint die Entscheidung über 6 Scheitelförderer und die aktive Positionierung des RV410 auf dem DCC-Markt umstritten. Die Zeit wird zeigen, ob es gerechtfertigt war.

Wir werden alle diese Annahmen bei späteren Synthese- und Spieltests überprüfen.

Technologische Innovationen

Generell gibt es im Vergleich zum R420 keine. Was an sich kein Nachteil ist. Im Vergleich zu NV43:- Pro Taktzyklus werden bis zu 8 Pixel in den Bildpuffer geschrieben.

- Bis zu 16 MSAA-Pixel (NV43 hat bis zu 8)

- 6 Vertex-Blöcke, was lobenswert ist, aber nur bei synthetischen Tests und DCC-Anwendungen auffallen kann

- Weniger flexible Shader (2.0b)

- Kein Floating Blending, das derzeit jedoch möglicherweise nur in DCC-Anwendungen benötigt wird.

Bevor wir uns mit der Karte selbst befassen, finden Sie hier eine Liste von Artikeln, die sich mit der Untersuchung früherer neuer Produkte befassen: NV40/R420. Schließlich ist bereits klar, dass die RV410-Architektur ein direkter Nachfolger der R420-Technologien ist (die Leistung des Chips wurde halbiert).

Theoretische und analytische Materialien und Rezensionen zu Grafikkarten, in denen die Funktionsmerkmale der GPUs ATI RADEON X800 (R420) und NVIDIA GeForce 6800 (NV40) erörtert werden

- NVIDIA GeForce 6800 Ultra (NV40). Teil 1 – Architekturfunktionen und synthetische Tests in D3D RightMark (einseitige Version)

- NVIDIA GeForce 6800 Ultra (NV40). Teil 1 – Architekturfunktionen und synthetische Tests in D3D RightMark (Option ist in Seiten unterteilt)

- NVIDIA GeForce 6800 Ultra (NV40). Teil 2 – Untersuchung der Leistung und Qualität in Gaming-Anwendungen (einseitige Version)

- NVIDIA GeForce 6800 Ultra (NV40). Teil 2 – eine Studie über Leistung und Qualität in Spieleanwendungen (die Option ist in Seiten unterteilt)

- Borodino-Kampf zwischen ATI RADEON X800 XT und NVIDIA GeForce 6800 Ultra – Bild zwei: 450 MHz für die zweite und neue Tests für beide Karten (einseitige Version)

- Borodino-Kampf zwischen ATI RADEON X800 XT und NVIDIA GeForce 6800 Ultra – Bild zwei: 450 MHz für die zweite und neue Tests für beide Karten (die Option ist in Seiten unterteilt)

- Borodino-Kampf zwischen RADEON X800 und GeForce 6800: Bild drei – Trilineare Filterung (synthetische Beispiele)

- Borodino-Kampf zwischen RADEON X800 und GeForce 6800: Bild vier: Filtertests basierend auf RightMark (einseitige Version)

- Borodino-Kampf zwischen RADEON X800 und GeForce 6800: Bild vier: Filtertests basierend auf RightMark (Variante in Seiten unterteilt)

- Borodino-Kampf zwischen ATI RADEON X800 und NVIDIA GeForce 6800 – Bild Fünf: Filtertests basierend auf Spielen (einseitige Version)

- Borodino-Kampf zwischen ATI RADEON X800 und NVIDIA GeForce 6800 – Bild Fünf: Filtertests basierend auf Spielen (die Option ist in Seiten unterteilt)

- Testbericht zur PowerColor RADEON X800 PRO Limited Edition, Hardware-Konvertierung von X800 PRO in X800 XT Platinum Edition (einseitige Version)

- Testbericht zur PowerColor RADEON X800 PRO Limited Edition, Hardware-Konvertierung des X800 PRO in die X800 XT Platinum Edition (die Option ist in Seiten unterteilt)

- Testbericht zu Leadtek WinFast A400 TDH, Leadtek WinFast A400 Ultra TDH basierend auf NVIDIA GeForce 6800/6800 Ultra (einseitige Version)

- Testbericht zu Leadtek WinFast A400 TDH, Leadtek WinFast A400 Ultra TDH basierend auf NVIDIA GeForce 6800/6800 Ultra (Option ist in Seiten unterteilt)

- Borodino-Kampf zwischen ATI RADEON X800 und NVIDIA GeForce 6800 – Szene Sechs: Filtern in Spielen (Fortsetzung) (einseitige Version)

- Borodino-Kampf zwischen ATI RADEON X800 und NVIDIA GeForce 6800 – Szene sechs: Filtern in Spielen (Fortsetzung) (Option in Seiten unterteilt)

- Ein kurzer Bericht über das Testen von FarCry v.1.2 und die erste Implementierung von Shader 3.0 in die Realität

- Kurzbericht zum Funktionstest moderner 3D-Karten in DOOM III (X800PRO/XT, GF6800/GT/Ultra, 9800XT/5950U)

- Chaintech Apogee GeForce 6800 Ultra basierend auf NVIDIA GeForce 6800 Ultra – Test in DOOM III mit „Optimierungen“

Ich möchte noch einmal betonen, dass heute nur der 1. Teil ist, der der Leistung neuer Produkte gewidmet ist. Auf die Qualitätskomponenten gehen wir später im zweiten Teil ein (3D-Qualität und Videowiedergabe).

Also Referenzkarte RADEON X700XT.

Wir sehen, dass das Design des Produkts eher dem X600XT ähnelt, nur dass der X700XT im Gegensatz zu diesem über Steckplätze auf der Rückseite der Platine verfügt, um eine 256-MB-Lösung zu erhalten. Die Platine verfügt außerdem über eine Stellfläche für die Montage von RAGE Theater (VIVO).

Kühlgerät.

ATI RADEON X700XT |

|

Dies ist ein ungewöhnlicher Kühler. Warum sticht er so heraus? Nun, zunächst einmal hat ATI für solche Karten bisher keine geschlossenen Kühler verwendet, durch die Luft gedrückt wird. Außerdem ist darauf zu achten, dass die Kühlersockel überhaupt nicht gegen die Speicherchips gedrückt werden! Sie sind so konzipiert, dass sie nur den Kern kühlen! Das zweite ist das Material, aus dem der Heizkörper besteht – Kupfer. Daher wirkt die Karte sehr schwer, wenn man sie in die Hand nimmt. Und das Wichtigste: Der Kühler ist sehr, sehr laut! Vor allem unter Last, wenn die Lüftergeschwindigkeit steigt. Ich werde weiter unten darüber sprechen. |  |

|

|

Es ist davon auszugehen, dass Hersteller solcher Karten Experimente mit eigenen Kühlern durchführen werden, da die Installation dessen, was ATI jetzt vorgeschlagen hat, auf Platinen äußerst unzumutbar ist.

Nun, da der Kühler entfernt wurde, bedeutet das, dass sie den Kristall gesehen haben. Vergleichen wir die Kerngrößen des RV410 und des R350. Warum R350? Nun, weil dieser Chip auch 8-Pixel-Pipelines hat und außerdem 2-mal weniger Vertex-Pipelines hat. Gleichzeitig beträgt seine Produktionstechnologie 0,15 Mikrometer, während der RV410 bereits mit einem technischen Verfahren von 0,11 Mikrometer hergestellt wird.

Nun, das Ergebnis ist aufgrund der Verringerung der Kerngröße aufgrund eines verfeinerten technischen Prozesses sehr vorhersehbar. Obwohl die Anzahl der Transistoren im Kristall überhaupt nicht abgenommen hat. Dennoch ist davon auszugehen, dass einige der Caches oder andere technologische Elemente zerschnitten wurden. Unsere Forschung wird zeigen...

Kommen wir nun zurück zu den Betriebstemperaturen der Karte und dem Geräusch ihres Kühlers. Dank der regelmäßigen Effizienz des RivaTuner-Autors Alexey Nikolaychuk unterstützt die nächste interne Betaversion des Dienstprogramms bereits RV410. Und darüber hinaus ist es nicht nur in der Lage, die Frequenzen der Karte zu ändern und zu steuern, sondern auch Temperaturen und Lüftergeschwindigkeiten zu überwachen. Dies konnten wir feststellen, als die Karte ohne externe Kühlung mit Standardfrequenzen lief geschlossener Fall:

Obwohl die Temperaturen nicht so stark anstiegen und nur unter 60 Grad lagen, verhielt sich der Kühler sehr „nervös“, wie im unteren Feld mit der Grafik zu sehen ist, wo man den Lüfterbetrieb in Prozent seines maximal möglichen Wertes sehen kann Geschwindigkeit. Und wie gesagt, es entsteht ein sehr unangenehmes Geräusch.

Da RivaTuner den Lüfter steuern kann, werden wir seinen Betrieb auf einen Pegel einstellen, bei dem das Geräusch nicht störend und nahezu unhörbar ist – das entspricht etwa 55–56 % seiner Drehzahlfähigkeit.

Es ist offensichtlich, dass die Erwärmung des Kerns und der Karte insgesamt nicht zu stark zugenommen hat und immer noch im Bereich liegt sichere Verwendung. Warum war eine solche Rückversicherung mit dem Kühler notwendig? Wir kennen die Antwort noch nicht und hoffen auf eine Klärung dieser Angelegenheit durch ATI.

Installation und Treiber

Prüfstandkonfigurationen:

- Computer basierend auf Pentium4 Overclocked 3200 MHz (Prescott)

- Prozessor Intel Pentium4 3600 MHz (225 MHz × 16; L2=1024 K, LGA775); Hyper-Threading aktiviert

- ABIT AA8 DuraMAX-Motherboard basierend auf dem i925X-Chipsatz;

- RAM 1 GB DDR2 SDRAM 300 MHz;

- Festplatte WD Caviar SE WD1600JD 160GB SATA.

- Computer basierend auf Athlon 64 3400+

- CPU AMD Athlon 64 3400+ (L2=1024K);

- systemisch ASUS-Board K8V SE Deluxe auf VIA K8T800-Chipsatz;

- RAM 1 GB DDR SDRAM PC3200;

- Seagate Barracuda 7200.7 80 GB SATA-Festplatte.

- Operationssaal Windows-System XP SP2; DirectX 9.0c;

- Monitore ViewSonic P810 (21") und Mitsubishi Diamond Pro 2070sb (21").

- ATI-Treiberversion 6.483 (CATALYST 4.10beta); NVIDIA-Version 65.76.

- Grafikkarten:

- NVIDIA GeForce FX 5950 Ultra, 475/950 MHz, 256 MB DDR, AGP

- NVIDIA GeForce 6800 Ultra, 425/1100 MHz, 256 MB GDDR3, AGP

- NVIDIA GeForce 6800 Ultra, 400/1100 MHz, 256 MB GDDR3, AGP

- NVIDIA GeForce 6800 GT, 350/1000 MHz, 256 MB GDDR3, AGP

- ASUS V9999GE (NVIDIA GeForce 6800, 350/1000 MHz, 256 MB GDDR3), AGP

- NVIDIA GeForce 6800, 325/700 MHz, 128 MB DDR, AGP

- NVIDIA GeForce 6800LE, 325/700 MHz, 128 MB DDR, AGP

- NVIDIA GeForce PCX5900, 350/550 MHz, 128 MB DDR, PCI-E

- NVIDIA GeForce PCX5750, 425/500 MHz, 128 MB DDR, PCI-E

- NVIDIA GeForce 6600GT, 500/1000 MHz, 128 MB GDDR3, PCI-E

- ATI EADEON 9800 PRO, 380/680 MHz, 128 MB DDR, AGP

- ATI EADEON 9800 XT, 412/730 MHz, 256 MB DDR, AGP

- ATI EADEON X800 XT PE, 520/1120 MHz, 256 MB DDR, AGP

- ATI EADEON X800 XT, 500/1000 MHz, 256 MB DDR, AGP

- ATI EADEON X800 PRO, 475/900 MHz, 256 MB DDR, AGP

- ATI EADEON X800 XT, 500/1000 MHz, 256 MB DDR, PCI-E

- ATI EADEON X600 XT, 500/760 MHz, 128 MB DDR, PCI-E

VSync ist deaktiviert.

Wie wir sehen, hat ATI zur Ankündigung der RADEON X700 auch eine neue Version des Treibersatzes vorbereitet. Sein Highlight ist CATALYST Kontrollzentrum Dieses Dienstprogramm wurde jedoch früher zusammen mit 4.9 offiziell veröffentlicht. Aber warum wird dieses spezielle Programm in diesem Material hervorgehoben? Die Antwort ist einfach: Nur durch CCC können wir von neuen Features wie anpassbaren Optimierungen in 3D profitieren.

Aber lasst uns die Dinge in Ordnung bringen. Zunächst muss gesagt werden, dass CCC sowohl im Hinblick auf den Platzbedarf auf der Festplatte als auch im Hinblick auf den Versand über das Internet sehr umfangreich ist. Plus die Microsoft .NET 1.1-Bibliothek, die zusätzlich 24 Megabyte wiegt. Aber ohne sie wird das SSS nicht funktionieren.

Ist solch ein Glück die Pumpkosten wert? Auf den ersten Blick scheint es sich zu lohnen. Aber wir müssen genauer hinschauen. Hier können Sie eine animierte GIF-Datei (920 KB!) herunterladen (oder öffnen), die alle CCC-Einstellungen demonstriert.

Und hier werden wir nur diejenigen ansprechen, die aus Sicht von Innovationen im Management interessant sind 3D-Grafik:

Wir sehen Einstellungen namens CATALYST A.I. Dazu gehören sogenannte Treiberoptimierungen für verschiedene Spiele sowie ein allgemeiner Plan für Filteroptimierungen (trilinear und anisotrop).

Es gibt drei Abstufungen:

- AUS (Deaktivieren)- Optimierungen vollständig deaktivieren. Es wird versprochen, dass es in diesem Fall keine Optimierungen mit Filterung und einen sehr vereinfachten Optimierungsalgorithmus für Anwendungen geben wird.

- Niedriger Standart)- Optimierungen für die Anwendungsarbeit und eine einfache Filteroptimierung werden ebenfalls durchgeführt

- HOCH (Fortgeschritten)- Alle Optimierungen funktionieren vollumfänglich.

Unten im Abschnitt zur Geschwindigkeitsanalyse stellen wir die Ergebnisse der Aktivierung aller drei Modi am Beispiel der X700XT in Bezug auf die Leistung vor. Wir werden den qualitativen Aspekt im folgenden Material analysieren.

Nach Angaben von ATI sind derzeit Optimierungen für folgende Spiele im Einsatz:

- Doom 3: KATALYSATOR K.I. ersetzt den Beleuchtungs-Shader durch ein mathematisches Äquivalent, arbeitet jedoch effizienter. Diese Optimierung verbessert die Leistung in einigen Szenen.

- Half Life 2 Engine (derzeit im Counter erhältlich Angriffsquelle Beta-Version): KATALYSATOR K.I. Enthält ein verbessertes Textur-Caching für diese Engine, was eine höhere Geschwindigkeit ermöglicht, insbesondere bei aktiver Anisotropie bei hohen Auflösungen.

- Unreal Tournament 2003/Unreal Tournament 2004: Der CATALYST-Treiber ist so modifiziert, dass die anisotrope Filterung (oder ihre Kombination mit bi- und trilinearer Filterung) immer von der Anwendung bestimmt wird und das Spiel selbst diese Funktionen enthält. Wenn der Benutzer in früheren Treibern die Anisotropie über den Treiber aktivierte, wurde nur die erste Texturierungsebene vom Trilinear verarbeitet. Ab dieser Treiberversion werden alle Texturebenen verarbeitet. Für dieselben Spiele ist ein verbessertes Niveau der Texturanalyse garantiert (dies gilt insbesondere für alle RADEON X-Produkte), um die Leistung ohne Qualitätsverlust zu steigern. Die Serien RADEON 9800, RADEON 9700 und RADEON 9500 arbeiten weiterhin im gleichen Modus (d. h. wie vor der KI).

- Splinter Cell, Race Driver, Prince of Persia, Crazy Taxi 3- für diese Spiele KI-Optimierungen laufen auf ein striktes Verbot des AA-Modus hinaus, den diese Spiele nicht unterstützen (d. h. selbst wenn der Benutzer versehentlich AA im Treiber erzwungen hat, passiert bei aktiver KI nichts, der Treiber erkennt das Spiel selbst und schaltet sich aus AA, falls erforderlich). Bisher konnte man in solchen Situationen Störungen oder sogar Spielabstürze beobachten.

Es scheint also eine sehr nützliche Sache zu sein. Geschwindigkeitsstudien werden uns das bestätigen. Aber was mit der Qualität passiert, erfahren wir später.

Wenn wir uns CCC weiter ansehen, wird vielleicht eine interessante Registerkarte eine Zusammenfassung aller Hauptschalter sein:

Ich würde empfehlen, von dieser Registerkarte aus mit der Verwaltung von 3D zu beginnen. Obwohl diejenigen, bei denen einzelne Funktionen angepasst werden, ihre Vorteile haben, zumindest darin, dass man durch einen kleinen dreidimensionalen Plot, der sich ständig im Fenster wiederholt, die Aktivierung einer bestimmten Funktion sehen kann.

Unabhängig davon möchte ich den größeren Komfort bei der Steuerung der Abtastfrequenzen (vertikaler Scan) erwähnen:

Nun, eine benutzerfreundlichere Oberfläche für die Arbeit mit dem Fernsehen:

Die Arbeit des CCC hat aber auch sehr große Nachteile. Erstens ist es die sehr ärgerliche Langsamkeit der Benutzeroberfläche. Nach dem Umstellen des einen oder anderen Schalters und Drücken von APLLY „squasht und wurst“ das Programm etwa eine halbe Minute lang, und manchmal fühlt es sich an, als wäre es eingefroren, und dann ist alles wiederhergestellt. Dies kann nervöse Benutzer entweder in einen Stupor oder eine Psychose versetzen oder zu der Entscheidung führen, diese Software wegzuwerfen.

ATI-Programmierer müssen also noch an etwas arbeiten. Und mehr.

In den Diagrammen mit der Bezeichnung ANIS16x wurden die Ergebnisse für die GeForce FX 5950 Ultra und GeForce PCX5900/5750 mit aktivem ANIS8x ermittelt.

Besonders hervorheben möchte ich, dass die Treiberoptimierungen standardmäßig aktiviert und auf LOW/STANDART eingestellt sind, sodass die Hauptvergleiche mit der Konkurrenz in diesem Betriebsmodus des X700XT durchgeführt wurden.

Testergebnisse

Bevor ich kurz auf die Qualität in 2D eingehe, möchte ich das noch einmal klarstellen Derzeit gibt es KEINE vollständige Methodik zur objektiven Bewertung dieses Parameters folgende Gründe:

- Bei fast allen modernen 3D-Beschleunigern kann die 2D-Qualität stark von der jeweiligen Instanz abhängen, und es ist physikalisch unmöglich, alle Karten zu verfolgen;

- Die 2D-Qualität hängt nicht nur von der Grafikkarte, sondern auch vom Monitor und dem Verbindungskabel ab;

- In letzter Zeit wurde dieser Parameter stark von Kombinationen beeinflusst: Monitor-Karte, das heißt, es gibt Monitore, die mit bestimmten Grafikkarten nicht „freundlich“ sind.

Hinsichtlich getestetes Exemplar, dann zusammen mit Mitsubishi Diamond Pro 2070sb Das Board zeigte in den folgenden Auflösungen und Frequenzen eine hervorragende Qualität:

| ATI RADEON X700XT | 1600x1200x85Hz, 1280x1024x120Hz, 1024x768x160Hz |

|---|

Synthetische Tests D3D RightMark

Die von uns verwendete Version des synthetischen Testpakets D3D RightMark Beta 4 (1050) und seine Beschreibung sind auf der Website verfügbar

Kartenliste:

- 6600 GT (500/500)

- X700XT (475/525)

- X800XT (520/560)

- 6800 Ultra (400/550)

Schauen wir uns zunächst einmal an, ob die angegebenen Eigenschaften (8 Pixel pro Takt usw.) der Realität entsprechen. Also:

Pixelfülltest

Spitzenleistung bei der Texturabtastung (Texelrate), FFP-Modus, für unterschiedliche Anzahlen von Texturen, die auf ein Pixel angewendet werden:

Füllrate des Bildpuffers (Füllrate, Pixelrate), FFP-Modus, für unterschiedliche Anzahl von Texturen, die auf einem Pixel überlagert sind:

![]()

Es gibt vollwertige 8 Pipelines und die Möglichkeit, bis zu 8 Pixel pro Taktzyklus aufzuzeichnen. Somit sehen wir einen Vorteil gegenüber NV43, allerdings nur im Fall einer oder keiner Texturierung. In den meisten realen Anwendungen ist die Anzahl der Texturen größer oder gleich zwei und die Karten zeigen ähnliche Ergebnisse.

Sehen wir uns an, wie die Shading-Geschwindigkeit von der Shader-Version abhängt:

![]()

![]()

![]()

Wie erwartet gibt es keine Überraschungen, was typisch für alle aktuellen Chips ist. Dank der großen Speicherbandbreite und der Möglichkeit, 8 Pixel pro Takt zu schreiben, schlägt der X700 den 6600 am meisten einfache Tests, wenn die Komplexität der Shaderlänge oder die Anzahl der Texturen auf vernünftige Werte ansteigt, wird dieser Unterschied ausgeglichen. Um in den Framebuffer zu schreiben, haben wir:

Und zum Sampling von Texturen:

Kein Wunder also, der erwartete Vorteil des X700 bei der Schattierung einzelner Texturen wurde bestätigt.

Geschwindigkeitstest zur Geometrieverarbeitung

Der einfachste Shader ist die Dreiecksdurchsatzgrenze:

Ein komplexerer Shader ist eine einfache Punktlichtquelle:

Und nun die schwierigste Aufgabe, drei Lichtquellen, und zum Vergleich in Varianten ohne Übergänge, mit statischer und dynamischer Steuerung der Ausführung:

In Sachen Geometrie zeigt der X700 für seine Klasse phänomenale Ergebnisse – er übertrifft sogar den 6800 Ultra, ganz zu schweigen von seinem direkten Konkurrenten, dem 6600 GT. Die Frage ist nur, inwieweit dieses enorme geometrische Potenzial durch Anwendungen genutzt, gefordert und erschlossen wird. Schließlich benötigt kein modernes Spiel eine solche Dreiecksbandbreite. Was DCC-Anwendungen betrifft, haben wir bereits die Bedeutung des Treibers (insbesondere OpenGL) und andere Aspekte erwähnt, in denen der 6600 vorteilhafter aussieht. Wie auch immer, herzlichen Glückwunsch an ATI – sie haben einen neuen Standard für geometrische Leistung gesetzt. Einen solch überwältigenden Sieg über einen direkten Konkurrenten in synthetischen Tests haben wir schon lange nicht mehr erlebt.

Pixel-Shader-Test

Die erste Gruppe von Shadern ist recht einfach für die Ausführung in Echtzeit, 1.1, 1.4 und 2.0:

Schauen wir uns nun komplexe Shader an:

Gesamt für Pixel-Shader:

Hier herrscht klare Gleichberechtigung – der X700 verliert oder gewinnt weder gegenüber dem 6600 GT. In diesem Fall sollten Sie jedoch auf sekundäre Faktoren wie die SM3-Unterstützung und andere zusätzliche Funktionen der neuesten NVIDIA-Architekturen achten. Vor diesem Hintergrund sehen die Ergebnisse des X700 nicht sehr beeindruckend aus – ATI hätte seinen Vorteil in der Einfachheit in einen Vorteil in der Geschwindigkeit umwandeln können, aber dieses Mal ist es nicht passiert. Aber unter sonst gleichen Bedingungen wird das NVIDIA-Produkt aufgrund seines technologischen Vorsprungs profitabler erscheinen.

HSR-Test

Erstens, Spitzeneffizienz (ohne Texturen und mit Texturen) abhängig von der Komplexität der Geometrie:

Besonderheiten gibt es nicht, das Verhalten des HSR-Systems ist durchaus ATI-typisch, durch die zusätzliche Hierarchieebene spürbar, aber nicht entscheidend effizienter (und anpassungsfähiger) als bei NVIDIA.

Point Sprites-Test.

![]()

![]()

Es ist logisch, dass bei großen Sprites ATI gewinnt – das Vorhandensein von 8 Blöcken zum Mischen und Aufzeichnen von Werten im Frame hat einen Effekt (denken Sie daran, dass Sprites normalerweise zum Zeichnen von Partikelsystemen verwendet werden, was fast immer Alpha impliziert Mischen). Bei den kleinen Chips sehen konkurrierende Chips fast gleich aus – der Engpass sind Treiber und DirectX.

MSAA-Test

4x MSAA gleicht die Fähigkeiten des X700 und des 6600GT aus, zumindest in diesem einfachen Test.

Beachten Sie, dass im Fall von 2x, das für beide Chips praktisch kostenlos ist, der X700 bei einfachen Einzeltexturaufgaben (potenziell) etwas stärker aussehen kann.

Synthetische Tests in 3DMark03: Fillrate Multitexturing

|

Synthetische Tests in 3DMark03: Vertex Shader

|

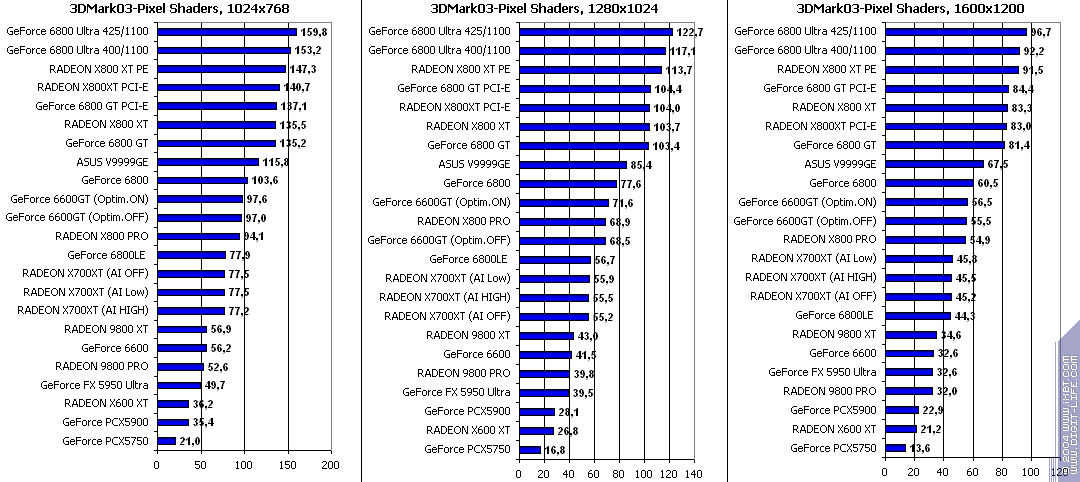

Synthetische Tests in 3DMark03: Pixel-Shader

|

Schlussfolgerungen zu synthetischen Tests

Die Chips sind weitgehend gleich. Wenn alle anderen Bedingungen gleich bleiben, spricht dies nicht für ATI – NVIDIA verfügt über ein größeres Übertaktungspotenzial und einen größeren architektonischen Vorteil. Zwei Hauptunterschiede:

- Ein spürbarer und lobenswerter Vorteil von ATI bei geometrischen Aufgaben ist der ungeschnittene Geometrieblock des R420

- Eine lästige, aber bei realen Aufgaben nicht so häufig auftretende NVIDIA-Verzögerung beim Shading und Schreiben in den Framebuffer bei einfachen Single-Texture-Shadern.

Daher ist es unmöglich, einen festen Anführer hervorzuheben; wir haben alle wichtigen interessanten Punkte notiert und kommentiert. Kommen wir nun zu praktischen Tests und prüfen, ob sie unsere Annahmen bestätigen:

Testergebnisse: Leistungsvergleich

Wir haben die folgenden Tools verwendet:

- Return to Castle Wolfenstein (MultiPlayer) (id Software/Activision) OpenGL, Multitexturing, ixbt0703-Demo, Testeinstellungen alles auf höchstmöglichem Niveau, S3TC AUS, Konfigurationen können sein

- Serious Sam: The Second Encounter v.1.05 (Croteam/GodGames) OpenGL, Multitexturing, ixbt0703-Demo, Testeinstellungen: Qualität, S3TC AUS

- Quake3 Arena v.1.17 (id Software/Activision) OpenGL, Multitexturing, ixbt0703-demo, Testeinstellungen sind alle auf der maximalen Stufe: Detailstufe Hoch, Texturdetailstufe Nr. 4, S3TC AUS, wird die Glätte gekrümmter Oberflächen mithilfe von Variablen drastisch erhöht r_subdivisions „1“ und r_lodCurveError „30000“ (Ich betone, dass der Standard-r_lodCurveError „250“ ist!), Konfigurationen können sein

- Unreal Tournament 2003 v.2225 (Digital Extreme/Epic Games) Direct3D, Vertex Shader, Hardware T&L, Dot3, Würfeltexturierung, Standardqualität

- Code Creatures Benchmark Pro (CodeCult) Spieletest, der die Leistung des Boards in DirectX 8.1, Shader, HW T&L demonstriert.

- Unreal II: The Awakening (Legend Ent./Epic Games) Direct3D, Vertex Shader, Hardware T&L, Dot3, Würfeltexturierung, Standardqualität

- RightMark 3D v.0.4 (eine der Spielszenen) DirectX 8.1, Dot3, Würfeltexturierung, Schattenpuffer, Vertex- und Pixel-Shader (1.1, 1.4).

- Tomb Raider: Angel of Darkness v.49 (Core Design/Eldos Software) DirectX 9.0, Paris5_4 Demo. Der Test wurde maximal durchgeführt bewährte Qualität, nur die Tiefenschärfe PS20 wurde ausgeschaltet.

- HALO: Combat Evolved (Microsoft) Direct3D, Vertex/Pixel Shaders 1.1/2.0, Hardware-T&L, maximale Qualität

- Half-Life2 (Valve/Sierra) DirectX 9.0, Demo (ixbt07. Die Tests wurden mit aktivierter anisotroper Filterung sowie im Heavy-Modus mit AA und Anisotropie durchgeführt.

- Tom Clancy's Splinter Cell v.1.2b (UbiSoft) Direct3D, Vertex/Pixel Shaders 1.1/2.0, Hardware-T&L, maximale Qualität (sehr hoch); Demo 1_1_2_Tbilisi

- Call of Duty (MultiPlayer) (Infinity Ward/Activision) OpenGL, Multitexturing, ixbt0104demo, Testeinstellungen alles auf höchstmöglichem Niveau, S3TC EIN

- FarCry 1.2 (Crytek/UbiSoft), DirectX 9.0, Multitexturing, demo01 (Forschung) (Starten Sie das Spiel mit der Option -DEVMODE), Testeinstellungen sind alle sehr hoch.

- DOOM III (id Software/Activision), OpenGL, Multitexturing, ixbt1-demo (33 MB) Testeinstellungen, alle von hoher Qualität. Um Ruckler zu optimieren und zu reduzieren, wurden Konfigurationsdateien mit Caching erstellt.

- 3DMark03 v.340 (FutureMark/Remedy), DirectX 8.1/9.0, Multitexturing; Spiel 1/2/3/4, MARKEN.

Wenn jemand Demo-Benchmarks erhalten möchte, die wir verwenden, schreiben Sie bitte an die E-Mail-Adresse des Autors.

Quake3 Arena

|

|

|

|

|

Die hellsten Modi ohne AA und Anisotropie: Dieser Test ist schon zu alt, er ist fast 5 Jahre alt und daher lohnt es sich kaum, Optimierungen dafür vorzunehmen (schließlich haben die meisten Tester Q3 schon lange aufgegeben). Deshalb sehen wir nahezu keine Auswirkungen von Optimierungen. Das X700XT und sein Konkurrent 6600GT sind nahezu gleich stark.

Mit aktiviertem AA: Hier spielt der X700XT seinen Vorteil aus, denn Schwäche Der 6600 hat das Schreiben in den Bildpuffer verzögert (8 Pixel werden in 2 Taktzyklen geschrieben).

Bei eingeschalteter Anisotropie passierte nichts dergleichen, die Konkurrenten waren gleich.

Der letzte härteste Modus mit AA und Anisotropie: Die Niederlage des 6600GT blieb durch AA bedingt.

Also allgemein:

- RADEON

- RADEON X700XT – vs. GeForce 6600GT unter Berücksichtigung der Komplexität des Tests und der Empfehlung, darin AA zu verwenden, verzeichnen wir den Sieg der X700XT;

- RADEON

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG nichts;

Serious Sam: Die zweite Begegnung

|

|

|

|

|

Die leichtesten Modi ohne AA und Anisotropie: Trotz der Abwesenheit dieses Spiels in der Liste der Spiele, die offiziell von ATI-Programmierern optimiert wurden, ist die Einbeziehung von A.I. Dennoch hat es eine beträchtliche Wirkung. Bei den Hauptkonkurrenten sehen wir beim X700XT eine deutliche Niederlage.

Mit aktiviertem AA: Die Optimierungen verstärken ihre Wirkung (natürlich im X700) und tragen leicht dazu bei, das NVIDIA-Produkt zu besiegen (obwohl der Hauptgrund für den Erfolg derselbe ist wie im vorherigen Test). Es ist interessant festzustellen, dass das Deaktivieren von Optimierungen auf dem 6600 in diesem Modus die Geschwindigkeit auf 1600 x 1200 erhöhte und nicht verringerte, wie man erwarten würde. Wahrscheinlich liegt ein Fehler im Treiber oder einer Funktion der Anwendung vor.

Mit aktivierter Anisotropie: Die Optimierungen bewirken auf dem X700 einfach Wunder (die Deaktivierung beim 6600GT hatte übrigens wenig mit der Geschwindigkeit zu tun), obwohl es insgesamt immer noch ein starker Verlierer gegenüber dem Konkurrenten 6600GT ist.

Der letzte, schwierigste Modus mit AA und Anisotropie: ein zweideutiges Ergebnis, da Niederlagen und Siege mit AA und AF dem X700XT Erfolg bei hohen Auflösungen (wo der 6600GT aufgrund von AA schwach ist) und Niederlagen bei niedrigen Auflösungen, wo die Geschwindigkeit, bescherten der NVIDIA-Produktrückgänge bei AA ist nicht so katastrophal.

Also allgemein:

- RADEON X700XT – im Vergleich zu RADEON 9800 XT (ATHLON64 3400+) ähnlich;

- RADEON X700XT – gegen GeForce 6600GT unter Berücksichtigung der Einbeziehung von AA und AF vergeben wir den Sieg bedingt an die X700XT;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – versus RADEON Es gibt also einen Grund, die Qualität dieses Spiels im nächsten Material zu untersuchen;

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Rückkehr zum Schloss Wolfenstein (Mehrspieler)

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: Der X700XT wird selbst bei den aggressivsten Optimierungen leicht beschädigt. Gleichzeitig liefert das X700, wie wir sehen, in diesem Spiel sehr erhebliche Dividenden (wiederum, obwohl das Spiel nicht in der von ATI bereitgestellten Spieleliste aufgeführt ist).

Mit aktiviertem AA: Auch hier ermöglicht der starke Abfall des 6600GT mit AA, dass der X700 den ersten Platz mit einem starken Vorsprung vor seinem Konkurrenten einnimmt. Es sei denn, Sie schalten die KI aus. Die Überlegenheit des X700XT beginnt zu schwinden.

Bei aktivierter Anisotropie: ungefähr gleichwertig mit dem 6600GT, jedoch mit aktiven Optimierungen. Wenn Sie sie ausschalten, verliert der X700XT den Kampf.

Der letzte härteste Modus mit AA und Anisotropie: Ein starker Vorteil in AA gibt dem X700XT das Recht auf den Sieg.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – im Vergleich zur RADEON zu);

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Code-Kreaturen

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: ein Sieg für den X700XT. Es gibt jedoch einen leichten Effekt durch Optimierungen.

Mit AA an: Interessantes Bild, einfach extrem interessant! Wenn wir Konkurrenten mit aktivierten Optimierungen vergleichen, sehen wir ein Paradoxon: Der X700XT, der bei 1024 x 768 mit einem starken Vorsprung gestartet war, ... verlor schnell seinen Vorsprung, alles lief auf Parität hinaus. Wenn Sie die Optimierungen deaktivieren, liegt der Sieg erneut beim X700XT. Wir sehen, dass NVIDIA mit AA nun einen sehr starken Effekt hat, also eine Geschwindigkeitssteigerung bei aktiver Optimierung des Trilinears. Und zwar bis zu 52 Prozent! Und wieder ein Grund für die Qualitätsforschung.

Mit aktivierter Anisotropie: von der Parität zum Sieg für den X700XT mit aktivierten Optimierungen und zur Niederlage gegen den Gegner mit deaktivierten Optimierungen. In der Prozenttabelle unten können Sie sehen, dass AF nun dazu geführt hat, dass die Geschwindigkeit des X700XT mit seiner Optimierung um 40-60 Prozent gestiegen ist. Im nächsten Teil werden wir uns mit der Qualität befassen.

Der letzte schwierigste Modus mit AA und Anisotropie: Alles ist mehrdeutig. Kein Wunder, denn als AA und AF getrennt waren, herrschte große Uneinigkeit.

Also allgemein:

- RADEON X700XT alles ist magisch;

- RADEON X700XT – im Vergleich zu RADEON 9800 XT (ATHLON64 3400+) ähnlich;

- RADEON

- RADEON

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – gegenüber RADEON

- RADEON X700XT mit HOHER OPTIMIERUNG – versus RADEON

Achten wir auf die Geschwindigkeitssteigerung, die die Optimierungen der GeForce 6600GT verleihen!

Unwirkliches Turnier 2003

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: Sieg für den X700XT, es gibt wenige Optimierungen, aber sie erhöhen die Geschwindigkeit.

Mit aktiviertem AA: Angesichts der Tatsache, dass die Optimierungen des 6600GT bei 1600 x 1200 zu einem Geschwindigkeitsabfall führten, sehen wir im Vergleich ohne sie, dass der X700XT seltsamerweise bei derselben Auflösung und mit einem sehr großen Vorsprung gegen seinen Gegner verlor. Obwohl die Einbeziehung von A.I. gab dem ATI-Produkt starke Trümpfe und insgesamt einen Sieg. Aber auch hier müssen wir die Qualität prüfen.

Bei aktivierter Anisotropie: Die AF-Optimierung im X700XT führte ebenfalls zu einem starken Geschwindigkeitssprung, sodass diese Karte gewinnt. Das Qualitätsproblem ist offen, wir werden es untersuchen.

Der letzte schwierigste Modus mit AA und Anisotropie: Trotz der Tatsache, dass bei 1600 x 1200 der Verlust bei AA zur endgültigen Niederlage des X700XT in dieser Auflösung führte, insgesamt ein Sieg für den X700XT, da es mehr Vorteile gibt.

Also allgemein:

- RADEON

- RADEON X700XT – im Vergleich zu RADEON 9800 XT (ATHLON64 3400+) ähnlich;

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON X700XT vs. GeForce 6800LE (ATHLON64 3400+) überraschend, aber wahr: Sieg! Die Auswirkungen der AF-Optimierungen sind so groß, dass sie die X700XT an die Spitze gebracht haben;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Dieses Spiel steht bei der Untersuchung der Grafikqualität bei aktivierter KI ganz oben auf der Liste.

Unreal II: Das Erwachen

|

|

|

|

|

Die leichtesten Modi ohne AA und Anisotropie: Der X700XT ist eine leichte Niederlage, Optimierungen bringen wenig Rendite.

Mit aktiviertem AA: Wie in den ersten Tests verliert der 6600GT mit AA stark an Geschwindigkeit, sodass der X700XT den Sieg davonträgt.

Bei aktivierter Anisotropie: ungefähre Kräftegleichheit, und sogar die Position des X700XT ist etwas besser. Aber nur, wenn die KI eingeschaltet ist; wenn Sie sie ausschalten, verliert der X700XT.

Der letzte schwierigste Modus mit AA und Anisotropie: AA punktet und gewinnt darin, Gesamtführung für den X700XT.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – im Vergleich zur RADEON

- RADEON X700XT mit HOHER OPTIMIERUNG – im Vergleich zur RADEON X700XT OHNE OPTIMIERUNG ähnlich, nur der Gewinn ist etwas höher;

RightMark 3D

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: Sieg für den X700XT. Und beachten Sie, dass das Einschalten von A.I. gab dieser Karte sehr gute Trümpfe. Was ist das? Optimierung für unseren Test? :-) Oder suchen manche generell nach günstigeren Möglichkeiten des Renderns? Nur eine trilineare Optimierung? - Zweifelhaft.

Bei eingeschaltetem AA ist alles beim Alten

Bei eingeschalteter Anisotropie: Ja, hier das Gleiche.

Der letzte, schwierigste Modus mit AA und Anisotropie: Sie können sich vorstellen, dass es nichts mehr zu sagen gibt.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – gegenüber RADEON X700XT OHNE OPTIMIERUNG gute Dividenden;

- RADEON X700XT mit HOHER OPTIMIERUNG – im Vergleich zur RADEON

TR:AoD, Paris5_4 DEMO

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: eine leichte Niederlage gegen den Gegner, hier spielt die reine Geschwindigkeit der Shader eine Rolle, und in Bezug auf die Kernfrequenz ist sie beim 6600GT etwas höher.

Mit eingeschaltetem AA: Wow... das X700XT ist ein kompletter Fehlschlag! Was ist das? - Fahrer? Sicherlich sind sie das. Schauen Sie, in diesem Modus bei 1600 x 1200 funktioniert AA beim X700XT nicht. Obwohl in anderen Spielen alles in Ordnung ist.

Bei aktivierter Anisotropie: ungefähre Parität.

Der letzte schwierigste Modus mit AA und Anisotropie: Niederlage des X700XT.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Niederlage;

- RADEON X700XT – im Vergleich zu RADEON 9800 XT (ATHLON64 3400+) ähnlich;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Achten Sie darauf, welchen Vorsprung der 6600GT bei Optimierungen in diesem Spiel hat, obwohl sie laut NVIDIA-Spezialisten die Arbeit an diesem Spiel nach dem Zusammenbruch seines Autorenteams schon vor langer Zeit aufgegeben haben.

FarCry, demo01

|

|

|

|

|

HIER GIBT ES AUCH NICHTS, WAS SPEZIELL ZU BEACHTEN IST! Ein kompletter Fehlschlag des X700XT in allen Belangen! Offensichtlich hat das Spiel die neue Karte nicht „verstanden“ (sowohl in Patch 1.1 als auch in 1.2 überprüft) und etwas war dafür nicht aktiviert, daher eine so beispiellose Niederlage!

Wenn eine solche Schande nach dem Verkauf der Karte und dem nächsten Patch für das Spiel nicht behoben wird, kann dem X700XT als Ganzes nur für ein solches Fiasko eine Niederlage zugesprochen werden. Obwohl, wie wir sehen, die Optimierungen funktionieren. Und wieder berühren sie die Anisotropie. Was bedeutet das: Qualität muss überprüft werden. Was ist jedoch im Falle eines solchen Fehlers zu überprüfen?

Call of Duty, ixbt04

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: ungefähr gleiche Stärke der Gegner. Obwohl Optimierungen für beide Karten Früchte tragen, ist der Gewinn für die X700XT etwas höher.

Mit aktivierter AA: Sieg für die X700XT! Dies liegt wiederum daran, dass der 6600GT das Schreiben in den Bildpuffer verzögert hat, was sich bei AA sehr negativ auswirkt.

Bei aktivierter Anisotropie ist das Bild umgekehrt, die 6600GT gewinnt bereits.

Der letzte, schwierigste Modus mit AA und Anisotropie: Im Allgemeinen hat diese Karte gewonnen, da der Vorteil in AA dem X700XT mehr Vorteile verschaffte.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – im Vergleich zu RADEON 9800 XT (ATHLON64 3400+) ähnlich;

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG mit aktiviertem AF und A.I. Der X700 erhält ordentliche Geschwindigkeitssteigerungen;

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

HALO: Combat Evolved

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: Niederlage des X700XT

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – vs. GeForce 6600GT Niederlage;

- RADEON X700XT – Sieg gegen GeForce 6800LE (ATHLON64 3400+) (!!!);

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – im Vergleich zu RADEON

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Half-Life2 (Beta): ixbt07-Demo

|

|

|

Mit eingeschalteter Anisotropie: Der X700XT ist besiegt und sehr stark!

Der letzte schwerste Modus mit AA und Anisotropie: Und nur die Tatsache, dass die 6600GT mit AA noch einmal deutlich sank, gab der X700XT die Chance, sich den Sieg zu sichern. Auch wenn es wieder Fehler gibt – bei 1600x1200 funktioniert AA wieder nicht.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON zusammen mit AF;

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Splittergruppe

|

|

|

Der X700XT ist in allen Belangen geschlagen (im Vergleich zum 6600GT).

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – gegenüber RADEON 9800 XT (ATHLON64 3400+) ungefähre Parität;

- RADEON X700XT – vs. GeForce 6600GT Niederlage;

- RADEON X700XT – gegen GeForce 6800LE (ATHLON64 3400+) ein großes Fiasko!;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG keine Auswirkung;

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

DOOM III

|

|

|

|

|

Ich denke, es macht keinen Sinn, einen Vergleich der X700XT/6600GT nach Modus in Betracht zu ziehen, wenn klar ist, dass die X700XT ein kompletter Verlierer ist!

Also allgemein:

- RADEON

- RADEON

- RADEON X700XT vs. GeForce 6600GT VOLLSTÄNDIGER AUSFALL X700XT;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) ÄHNLICH;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG wow!!! Schauen Sie, wie viel Optimierung dieses Spiel bringt!!! Eine Untersuchung der Qualität ist dringend erforderlich, auch wenn sie angesichts der enormen Anzahl düsterer Szenen, in denen man wenig sieht, sehr, sehr schwierig ist;

- RADEON X700XT mit HOHER OPTIMIERUNG – versus RADEON X700XT OHNE OPTIMIERUNG analog;

Und achten Sie darauf, wie vernachlässigbar die Optimierungen für den 6600GT sind, wobei wir berücksichtigen müssen, dass dies nur für Trilinear und AF gilt und nicht für die Optimierung für das Spiel im Allgemeinen (einschließlich des Ersetzens von Shader).

3DMark03:Game1

|

|

|

|

|

Die einfachsten Modi ohne AA und Anisotropie: ungefähre Parität bei Optimierungen und Verlust für den X700XT ohne sie. Die Einbeziehung von KI, insbesondere von High, zahlt sich aus.

Mit aktivierter AA: Sieg für die X700XT, wenn man das katastrophale Verhalten der 6600GT mit AA berücksichtigt.

Bei aktivierter Anisotropie: Nur im Optimierungsmodus „Hoch“ schafft es die X700XT, sich den Sieg zu sichern, in anderen Fällen liegt die Spitzenreiterin bei der 6600GT. Optimierungen für AF hier im X700 sind sehr fruchtbar. Wir müssen die Qualität untersuchen.

Der letzte, schwierigste Modus mit AA und Anisotropie: Dank AA gelang es der ATI-Karte, das Trikot des Führenden zu ergattern, allerdings nur, wenn die hohe Optimierung aktiviert war.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – Sieg gegen GeForce 6600GT nur mit High A.I.;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – im Vergleich zur RADEON X700XT OHNE OPTIMIERUNG ist der Effekt offensichtlich;

- RADEON X700XT mit HOHER OPTIMIERUNG – im Vergleich zur RADEON

3DMark03:Game2

|

|

|

|

|

Das X700XT verliert in allen Modi gegenüber seinem Konkurrenten 6600GT. Optimierungen helfen zwar einigermaßen, aber nur schwach.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – vs. GeForce 6600GT Niederlage;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

Die Qualität muss sich sehen lassen, obwohl die gesamte Bühne dunkel ist, wird es schwierig sein, etwas zu finden.

3DMark03:Game3

|

|

|

|

|

Die hellsten Modi ohne AA und Anisotropie: Optimierungen am X700 arbeiten mit dem gleichen Potenzial wie im vorherigen Test. Und im Allgemeinen können wir sagen, dass sie wenig gegeben haben, weil... Der X700 hat sogar den Kampf mit ihnen verloren.

Mit aktivierter AA: nahezu gleichauf mit dem Gegner

Bei aktivierter Anisotropie: ähnlich

Der letzte, schwierigste Modus mit AA und Anisotropie: Parität mit dem 6600GT bei aktiven Optimierungen und Niederlage bei ausgeschalteten Optimierungen.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT - im Vergleich zur GeForce 6600GT setzen wir bedingt Parität;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) Niederlage;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG kleiner Effekt;

- RADEON X700XT mit HOHER OPTIMIERUNG – vs. RADEON X700XT OHNE OPTIMIERUNG ähnlich;

3DMark03:Game4

|

|

|

|

|

Ein überzeugender und brillanter Sieg für die X700XT in allen Modi!

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON X700XT – Sieg gegen GeForce 6800LE (ATHLON64 3400+);

3DMark03: MARKIERUNGEN

|

|

|

|

|

Und so gewinnt das X700XT nach dem starken Einfluss des vorherigen Tests fast überall. Darüber hinaus sorgen Optimierungen (KI) für eine ordentliche Steigerung.

Also allgemein:

- RADEON X700XT – vs. RADEON 9800 PRO (ATHLON64 3400+) Sieg;

- RADEON X700XT – Sieg gegen RADEON 9800 XT (ATHLON64 3400+);

- RADEON X700XT – Sieg gegen GeForce 6600GT;

- RADEON X700XT – vs. GeForce 6800LE (ATHLON64 3400+) bedingte Parität;

- RADEON X700XT mit NIEDRIGER OPTIMIERUNG – im Vergleich zur RADEON X700XT OHNE OPTIMIERUNG gibt es einen Effekt;

- RADEON X700XT mit HOHER OPTIMIERUNG – im Vergleich zu RADEON X700XT OHNE OPTIMIERUNG dasselbe;

Schlussfolgerungen

Etwas zusammenfassen:

- Angesichts der zahlreichen, wenn auch leichten Siege des X700XT über seinen Hauptkonkurrenten, die GeForce 6600GT, könnte man viele warme Worte über das neue Produkt von ATI sagen, aber ...

- Der obskure und kolossale Misserfolg der Karte in Far Cry sowie der erwartete Verlust in DOOM III (diese beiden Hit-Spiele!) und die schlechten Ergebnisse in HL2 geben uns einen Grund, die Führung nicht bekannt zu geben und sie nicht an den X700XT zu vergeben

- Der Wermutstropfen ist der kühlere Lärm, der, wie unsere Recherche gezeigt hat, ungerechtfertigt ist.

- Auch wenn es weit hergeholt ist, die GeForce 6600GT mit der RADEON

- Wir haben das Übertakten des X700XT aus zwei Gründen nicht in Betracht gezogen: Zeitmangel und geringes Potenzial (die Karte friert ein, selbst wenn der Kern auf 505 MHz eingestellt ist), während das Übertaktungspotenzial des 6600GT hervorragend ist und es daher für NVIDIA nicht schwierig sein wird die nächste Revision der Karte mit erhöhten Frequenzen herauszubringen und so alle schwachen Geschwindigkeitsvorteile des X700XT zu beseitigen).

- Das Schöne daran ist, dass der X700XT tatsächlich schneller ist als seine vorherigen Brüder aus dem High-End-Lager: 9800PRO/9800XT. Und natürlich GeForce FX 5950U. Vergessen wir jedoch nicht, dass diese Karten aus unterschiedlichen Sektoren stammen (PCX und AGP) und es daher nicht ganz richtig ist, sie zu vergleichen. Dennoch muss der Benutzer beim Wechsel zu einer anderen Plattform die Konfiguration ändern und ein einfacher direkter Vergleich ist falsch.

Wir müssen also zunächst hoffen, dass bald ein Treiber (oder Patch für das Spiel) veröffentlicht wird, der einen solchen Fehler in Far Cry behebt; Zweitens muss ATI wahrscheinlich seinen Appetit auf 249 US-Dollar für eine 256-MB-Karte zügeln und die Preise um 40 bis 50 US-Dollar senken, während es auf die Veröffentlichung einer leistungsstärkeren Karte von NVIDIA aus derselben 6600-Familie wartet.

Drittens erinnern wir uns alle daran lange Zeit ATI-Produkte waren nur deshalb die Favoriten, weil sie im Vergleich zu ihren Konkurrenten von NVIDIA eine deutlich höhere Geschwindigkeit bei Shader-Spielen aufwiesen. Und um an erster Stelle zu bleiben, musste das kanadische Unternehmen ein Produkt herstellen, das nicht (bedingt) die gleiche Produktivität aufweist, sondern dem Konkurrenten um einen spürbaren Prozentsatz überlegen ist. Und berücksichtigen Sie auch den ordentlichen Spielraum für die Frequenzerhöhung beim 6600GT (der seltsamerweise beim X700XT nicht beobachtet wird, obwohl beide Produkte nach dem gleichen technischen Verfahren hergestellt werden).

ATI hat immer noch seine eigene „Himbeere“ im AGP-Sektor, wo NVIDIA heute nur noch die alte und schwache FX 5700 für 150-200 US-Dollar anbietet. Das ist eine gute Chance und deshalb ist es seltsam zu sehen, dass Kanadier immer noch versuchen, in diesem Bereich mitzuspielen Sektor mit dem Einsatz der 9800 PRO (die, wie Tests gezeigt haben, eindeutig nicht konkurrenzfähig zu neuen Middle-Lösungen ist), anstatt auch hier die X700-Reihe einzuführen und dabei den Umstand auszunutzen, dass NVIDIA in diesem Sektor derzeit weit zurückliegt. Es konnten verschiedene Revisionen des RV410 vorgenommen werden (mit AGP- und PCX-Schnittstellen). Schade, aber ATI hat diesen Punkt praktisch verfehlt – es ist unwahrscheinlich, dass das Unternehmen Zeit zum Reagieren haben wird, bevor wahrscheinlich neue AGP-Lösungen von NVIDIA auftauchen.

Es ist interessant, dass sowohl dieses Unternehmen als auch dieses Unternehmen nun mit beneidenswerter Konsequenz, die PCI-E den Vorrang einräumt, OEM-Monteure tatsächlich dazu zwingen, auf PCI-E umzusteigen neue Plattform, was für Intel sehr vorteilhaft ist, für normale Verbraucher und in der Tat für die meisten OEM-Monteure überhaupt nicht von Vorteil ist. Offenbar steht hinter der eifrigen PCI-Express-Initiative beider Grafikführer irgendwie der Schatten von Intel.

Kehren wir nun zu ATI zurück. Führung muss ständig gefördert werden! Und bringen Sie nicht alle drei Jahre ein erfolgreiches Produkt auf den Markt und ruhen Sie sich dann auf Ihren Lorbeeren aus. Und wenn Kanada das nicht versteht, wird es bald die Mütze (oder das T-Shirt?) seines Anführers verlieren. Man könnte stolz auf den X800XT PE sein, wie stark und leistungsstark er ist, aber er ist einfach noch nicht im Handel erhältlich. Mit einer Papierkrone erobert man kein Land, und man schwört ihr nicht die Treue ...

Wir werden unsere Forschung fortsetzen, daher können wir kein endgültiges Urteil fällen; Qualitätsforschung wird ihren Beitrag leisten, neue Treiber werden veröffentlicht und möglicherweise offensichtliche Mängel behoben. Der Massenverkauf wird beginnen, Produkte verschiedener Anbieter werden auf den Markt kommen, dann werden wir sehen, wer gewinnt….

Nun zu CATALYST neue Version und seine Innovationen. Es ist sehr lobenswert und erfreulich zu sehen, dass den Nutzern die Möglichkeit gegeben wurde, selbst zu entscheiden, was sie vereinfachen möchten und was nicht. Hier geht es um K.I. Wir werden aber auch prüfen, was genau ein- und ausgeschaltet wird, wenn innerhalb der KI von einem Modus in einen anderen gewechselt wird. Deshalb können wir auch noch kein Urteil fällen. Aber was die Langsamkeit des CCC selbst angeht, möchte ich sehr starke, hitzige Worte mit einer deutlich negativen Tendenz sagen. Denn es ist eine Schande, wenn ein Programm auf einem leistungsstarken Computer unheimlich langsam ist. Wir hoffen, dass dieser Punkt von den Entwicklern in naher Zukunft berücksichtigt wird. Lassen Sie uns im Allgemeinen wiederholen, dass die Idee von A.I. sehr gut, ebenso wie CCC im Allgemeinen.

Ausführlichere Vergleichseigenschaften von Grafikkarten dieser und anderer Klassen finden Sie auch in unseren 3DGiToges.

Erinnern wir uns noch einmal daran, dass dies nur der erste Teil unseres mehrteiligen Materials zum RV410 ist! Seien Sie gespannt auf die Fortsetzung!

Seit über einem Jahr ist nVidia konstant Marktführer Computergrafik, und die Führung war so stark und stabil, dass niemand auch nur an einen möglichen Führungswechsel dachte.

Als wir uns an die alten Zeiten erinnerten, kamen wir zu dem Schluss, dass das konkurrenzfähigste Modell der letzten Zeit die Radeon HD 2900XT war, die jedoch die GeForce 8800 GTX immer noch nicht übertreffen konnte. Doch letztes Jahr erschien die Radeon HD 3870, die im Vergleich zu ihren Konkurrenten leider erneut kaum ernsthafte Chancen auf „Gold“ hat, obwohl sie ihre Mission – die Anhebung der Preismaßstäbe für die meisten ähnlichen Produkte – voll und ganz erfüllt hat.

Das Jahr 2008 hat begonnen und nVidia hat der Öffentlichkeit noch kein echtes Next-Gen-Produkt präsentiert, das im Vergleich zu allen bisherigen Produkten des Unternehmens wirklich nach vorne kommen könnte. Gleichzeitig hofften wir, dass AMD/ATI ihre Versprechen einhalten würden, eine Dual-GPU auf Basis der Radeon HD 3800 zu entwickeln, die im Gegensatz zu herkömmlichen Multi-GPUs nicht ordnungsgemäß funktionieren muss. Plattformen für zwei kompatible Grafikkarten ( Crossfire-Technologie) und das zu einem soliden Konkurrenten auf dem Markt für hochwertige Grafiken werden kann.

Die Entwickler der Radeon HD 3870 X2 haben zwei Grafikprozessoren (GPU) auf einer Platine untergebracht

Ehrlich gesagt standen wir der Radeon HD 3870 Die Einführung einer Karte für die Crossfire-Technologie – ursprünglich eine Technologie zur Kreuzfunktion zweier Grafikkarten – könnte zu enormen Verzögerungen bei der Produktveröffentlichung und einem völligen Rückgang der Attraktivität von Geräten für Verbraucher führen. Tatsächlich konnte AMD, wie die Praxis gezeigt hat, alle Aussagen zur Funktionalität seines neuen Produkts bestätigen, denn Die Entwickler haben die Produktion der Radeon HD 3870

Wie Sie wahrscheinlich bereits vermutet haben, besteht die ATI Radeon HD 3870 X2 im Wesentlichen aus zwei Radeon HD 3870-Grafikprozessoren, die auf einer Leiterplatte (PCB) untergebracht sind. Zur Organisation werden Prozessoren eingesetzt Zusammenarbeit PCI Express 1.1 Bridge, die stark an den Crossover-Betrieb von ATI-Grafikkarten erinnert. Doch auch wenn das X2 eindeutig als Einkartengerät konzipiert ist, können Sie dennoch zwei Grafikkarten funktionsübergreifend betreiben. Dies bedeutet, dass mit einem entsprechend ausgewählten Treiber der Betrieb eines Zwei-Bit-Systems im Crossover-Modus Realität geworden ist.

Lange bevor wir den X2 tatsächlich getestet haben, glaubten wir, dass die Dual-Radeon-3870-GPUs eine recht gute Leistung erbringen würden, rechneten aber auch damit, dass der X2, wie bei Standard-Dual-SLI-Karten und Crossfire, während des Spiels etwas Jitter verspüren würde. Im Prinzip ist es so gekommen – weitere Details finden Sie in der Beschreibung unserer Benchmark-Tests.

Ein großer Vorteil des Radeon-Designs besteht darin, dass der Benutzer nicht auf die Eigenschaften von Treibern und Chipsätzen angewiesen ist (schließlich befinden sich beide GPUs auf derselben Platine). Es ist erwähnenswert, dass moderne Treiber (Catalyst 8.1 und 8.45) uns etwas „unausgereift“ erscheinen. Während das System im Test grundsätzlich zuverlässig funktionierte, kam es manchmal zu diversen Störungen, die beim Spielen eines bestimmten Computerspiels nicht typisch sind. Ist das eine Konsequenz? unter Verwendung von Windows Ob Vista Ultimate 64-Bit oder nicht, ist noch nicht klar.

Zahlen

Heutzutage entwickeln viele Hersteller auf der ganzen Welt mehr denn je Grafikkarten, die vollständig den Designmustern von ATI und nVidia folgen. und die Radeon HD 3870 X2 bildet da keine Ausnahme, da die meisten der verwendeten Karten mit ATI-Karten identisch sind. Und doch konnten wir in der kurzen Zeit, in der dieses Produkt verfügbar war, völlig unterschiedliche Karten von ASUS finden. Ihre Unterschiede waren ein verbessertes Kühlsystem, das Vorhandensein von vier DVI-Anschlüssen und eine leicht veränderte Frequenz des Speichers und des Mikroprozessorkerns. Im Übrigen sind die Karten genau gleich.

Von den Abmessungen her ist die ATI Radeon HD 3870 Allerdings liegen die Abmessungen des X2 sehr nahe an den Abmessungen der GeForce 8800 GTX/Ultra, sodass diese Zahlen niemanden sonderlich überraschen werden. Was das Design selbst betrifft, weist die ASUS-Version einige offensichtliche Unterschiede auf, und wir denken, dass dies ein klarer Pluspunkt für dieses Produkt ist.

Anstatt eine Standard-Kunststoffschale zum Schutz vor Überhitzung zu verwenden, hat ASUS zu diesem Zweck ein schwarzes Aluminiumgehäuse entwickelt, an dem sich zwei Belüftungslöcher (jeweils 65 cm Durchmesser) zur Kühlung der beiden im Board verbauten Grafikprozessoren befinden. Wenn man dieses Gehäuse entfernt, werden zwei Reihen feinmaschiger Aluminiumplatten sichtbar, wobei die zweite Plattenreihe deutlich mehr aufweist. Jede dieser Platten ist über zwei Heatpipes mit einer Kupferplatine verbunden. Tatsächlich ist ein solches Kühlsystem radikaler als sein eigenes Standardoptionen, und wie es uns schien, hat es manchmal einfach nicht genug Kraft.

Neben dem neuen Ansatz des Kühlsystems fällt Ihnen auch eine große Stahlplatte mit der Aufschrift „DUAL“ auf, die sich auf der Vorderseite der Grafikkarte befindet. Schaut man sich die Rückplatte genau an, stellt man außerdem fest, dass es nicht zwei, sondern vier DVI-Anschlüsse gibt, was typisch für Geräte mit Crossfire-Technologie ist. Diejenigen, die sich sehr für die Möglichkeit des Anschlusses von LCD-Monitoren interessieren, werden von dieser Entdeckung fasziniert sein, denn bei Verwendung von zwei Grafikkarten erhöht sich die Anzahl der DVI-Anschlüsse auf 8!

Die Speicherkapazität der ATI Radeon HD 3870 X2 beträgt 1 GB (512 MB für jede GPU). Technische Anforderungen Der Standardwert für eine bestimmte Speichermenge beträgt 1800 MHz, obwohl ASUS die Frequenz bei den fortschrittlichsten Versionen seiner Geräte auf 1910 MHz erhöht hat. Darüber hinaus ist jeder Prozessor für den Betrieb mit 825 MHz ausgelegt, während ASUS seine Top-Versionen für den Betrieb mit 850 MHz ausgelegt hat. Dies entspricht einer Erhöhung des Frequenzniveaus für jede GPU um 3 %, aber wir können uns gut vorstellen, wie sehr sich die Einstellung der Hersteller gegenüber Standardlösungen für das Board-Design verändert hat.

Idealerweise können Geräte von ASUS auf 1 GB GDDR3 .8ns Speicher von Hynix „HY5RS123235B FP-08“ zurückgreifen, wodurch das Board recht flott arbeitet. Es gelang uns, eine Frequenz von 2122 MHz zu erreichen, bevor das System auszufallen begann. Bei Mikroprozessoren lag die Beschränkung des oben genannten Parameters bei 861 MHz, also nur 11 MHz mehr als zuvor.

Benchmarks: technische Eigenschaften und auf Crysis testen

Technische Eigenschaften: Hardware (Hardware)

- Intel Core Prozessor 2 Duo E8400 (3,00 GHz) LGA775

- x2 OCZ DDR3 PC3-12800 FlexXLC Edition-Modul(e)

- x2 OCZ DDR2 PC2-6400 CL4 FlexXLC Edition-Modul(e)

- ASUS P5N-T Deluxe (nVidia nForce 780i SLI)

- ASUS P5E3 Deluxe (Intel X38)

- OCZ GameXStream (700 Watt)

- Seagate 500 GB 7200 U/min (Serial ATA II)

- ASUS Radeon HD 3870 X2 (1 GB) - ATI Catalyst 8.4

- ASUS GeForce 8800 GTX (768 MB)

- ASUS GeForce 8800 GT (512 MB) SLI

- ASUS GeForce 8800 GT (512 MB)

- ASUS Radeon HD 3870 (512 MB) Crossfire - ATI Catalyst 8.1

- ASUS Radeon HD 3870 (512 MB) - ATI Catalyst 8.1

Software:

-Microsoft Windows Vista Ultimativ (64-Bit)

- nForce 9.46

- Intel Systemtreiber 8.4.0.1016

- nVidia Forceware 169.28

-ATI Catalyst 8.4

-ATI Catalyst 8.1

Wie Sie sehen können, ist die Radeon HD 3870 Allerdings ist die Radeon HD 3870 X2 damit die schnellste Karte grafische Werkzeuge, vor der GeForce 8800 GTX. Für alle Crysis-Fans ist die GeForce 8800 GTX-Karte jedoch immer noch die beste Karte für dieses Spiel.

Benchmark: Company of Heroes

Auch hier stellen wir fest, dass die Radeon HD 3870 Während die Radeon HD 3870

Benchmark: F.E.A.R

Zum ersten Mal stellten wir fest, dass die Radeon HD 3870 X2 beim Betrieb mit zwei Crossfire-Karten deutliche Vorteile zeigte. Mit einer Erweiterung von 1920 um 1200 und 4 auf AA/16xAF war die 3870 X2 27 % schneller als Crossfire, mit einer leichten Steigerung von 1 fps gegenüber der GeForce 8800 GT SLI. Kontinuierliche Leistung in FEAR, kein Zweifel!

Benchmark: PREY

Die Benchmark-Ergebnisse von Prey sind sehr interessant, und auch wenn das Spiel etwas veraltet ist, wollten wir unsere Recherche hier sinnvoll gestalten. Ohne AA/AF übertrifft die Radeon HD 3870 Die Radeon HD 3870 Crossfire-Karte liegt in zwei von drei Tests hinter den anderen.

Maßstab: Oberbefehlshaber

Wie die meisten hier getesteten Spiele zeigt Supreme Commander, dass die Radeon HD 3870 X2 dem Radeon HD 3870 Crossfire-Setup nur geringfügig überlegen ist.

Da die Radeon HD 3870 die Kanten in Supreme Commander gut glättet, war es für uns keine Überraschung, dass die X2 beide Karten übertrifft: die einzelne GeForce 8800 GTX und die SLI GeForce 8800 GT.

Benchmark: UT3, Welt im Konflikt

Die Radeon HD 3870 X2 konnte das 3870 Crossfire-Setup um 6-7 fps übertreffen. Allerdings wurde sie von der GeForce mit 1440 mal 900 und 1680 mal 1050 überholt, sodass die Auflösung bei maximal 1920 mal 1200 blieb.

World Conflict zeigt gemischte (unterschiedliche) Ergebnisse, obwohl alle Karten ähnlich abgeschnitten haben. Die Radeon HD 3870 X2 war bei der Testauflösung von 1440 x 900 die schnellste Lösung, die GeForce 8800 GTX-Grafik war jedoch etwas besser.

Leistungs- und Temperaturaufnahme

Bei Verwendung einer einzelnen Karte verbraucht die Radeon HD 3870 X2 im Leerlauf etwas weniger Strom als die GeForce 8800 GTX, benötigt unter Last aber deutlich mehr Strom. Tatsächlich verbraucht die 3870 X2 beim Einsatz in Crysis 23 % mehr Strom als die GeForce 8800 GTX.

Im Vergleich zur Crossfire Radeon HD 3870-Technologie stellen wir fest, dass die 3870 X2 9 % weniger Strom verbraucht. Das ist nicht wie bei anderen Ergebnissen, die wir online gesehen haben, aber wir können Sie davon überzeugen, dass wir unsere Messungen dreifach überprüft haben.

Wir freuen uns sehr über die gute Leistung der verbesserten Kühllösung von ASUS, da der Extreme AH3870X2 etwas kühler lief als die Radeon HD 3870-Karte allein. Allerdings sind 80 Grad für unseren Geschmack sozusagen immer noch zu viel, bei all der heißen Luft, die um den Körper zirkuliert. Ich denke, wir müssen warten, bis Arctic-Cooling Accelero Xtreme für die Radeon HD 3870 X2 entwickelt, bevor wir bessere Temperaturen sehen.

Abschließende Gedanken

Besser spät als nie, AMD/ATI haben es geschafft! Es besteht kein Zweifel, dass die Radeon HD 3870 X2 die derzeit schnellste verfügbare Einzelkarte ist.

Wir waren von den Fähigkeiten beeindruckt neue Radeon Karten. Vor allem, weil man nach der Installation leicht vergisst, dass wir mit zwei GPUs gearbeitet haben. Der 3870 X2 lief bei jedem Spiel, für das wir ihn verwendeten, reibungslos. Es gab keinen bürokratischen Aufwand, der normalerweise mit Crossfire einhergeht. Wir konnten uns beim Spielen einfach zurücklehnen und entspannen.

Die Radeon HD 3870 X2 erwies sich als stabiler als zunächst erwartet, denn... Die Leistung war der Radeon HD 3870 Crossfire sehr ähnlich. Ein weiterer Vorteil besteht darin, dass die Radeon HD 3870 Hauptplatine, mit PCI Express x16-Anschluss.

Abgesehen von dem seltsamen Knallgeräusch hier und da, das unserer Meinung nach rein treiberbedingt war, schnitt die ATI Radeon HD 3870 X2-Karte perfekt ab. Wir hoffen natürlich, dass diese kleineren Stabilitätsprobleme in der nächsten Catalyst-Treiberversion behoben werden. Ein weiterer Nachteil ist, dass die Karte heißer wird als uns lieb ist und viel heiße Luft im Gehäuse zurückbleibt. Dies ist jedoch nicht verwunderlich, da die Karten der neuen Generation und die X2-Karten fast die gleiche Menge Wärme (heiße Luft) produzieren.

Wir sind mit den Erfolgen von ATI zufrieden, obwohl es etwas ironisch ist, dass sie mit einem vorhandenen Produkt hierher gekommen sind, was ihren Sieg weniger beeindruckend macht. Aus heutiger Sicht könnte Nvidia einen Weg finden, das Ruder herumzureißen und eine Dual-Karte auf Basis der G92 zu entwickeln, die Nvidia wieder an die Spitze bringen würde.

Aber wenn wir streng von der Gegenwart sprechen, haben wir aus materieller Sicht vor kurzem zwei gekauft ATI-Karten Radeon HD 3870 X2 für etwa 460 $. Und indem wir eine Liste der Vorteile bereitstellen, die das SLI-Setup in einigen Tests gegenüber der Radeon HD 3870 X2 hatte, müssen wir darüber nachdenken, was der bessere Kauf ist. Darüber hinaus kosten GeForce 8800 GT 256 MB-Karten knapp über 400 US-Dollar, was unsere Wahl noch schwieriger machen wird.

Die Radeon HD 3870 Mal sehen, was uns nVidia in ein paar Monaten zeigt.

Als sie 2004 auf den Markt kamen, gehörten Radeon 9200-Grafikbeschleuniger zur Einsteigerklasse. Die Leistung der ATI Radeon 9200-Grafikkarte reichte völlig aus, um die damals häufigsten Aufgaben zu lösen. Dieser Adapter lief am meisten Computerspiele. Heutzutage ist diese Grafikkarte integrierten Grafiklösungen leistungsmäßig unterlegen. Wir werden seine Fähigkeiten und technischen Eigenschaften in diesem Material betrachten.

ATI Radeon 9200: An welches Marktsegment richtet sich der Adapter?

Im Jahr 2004 wurde der Grafikkartenmarkt von zwei Herstellern dominiert. Dies sind Nvidia- und ATI-Unternehmen. Wenn vor der Veröffentlichung der Produkte der Radeon 9XXX-Serie die führende Position von Geräten von Nvidia eingenommen wurde, änderte sich die Situation nach der Veröffentlichung des ersten Radeon 9XXX-Grafikadapters dramatisch. In puncto Geschwindigkeit und Leistung belegten Adapter des ATI-Entwicklers den ersten Platz. Der gesamte diskrete Grafikmarkt wurde in drei große Segmente unterteilt.

- Grafikkarten Einstiegslevel. Diese Geräte zeichneten sich durch minimale Leistung und einen recht günstigen Preis aus. Die meisten PC-Systemeinheiten der damaligen Zeit enthielten solche Grafikadapter. Hersteller Nvidia positionierte für diesen Teil des Marktes Produkte der Serien GeForceFX-5200 und GeForce 4MX 4XX. Der Hersteller ATI stellte ihnen wiederum nur ein Produkt entgegen – Radeon. Wenn wir diese Beschleuniger hinsichtlich der Produktivität vergleichen, war der Held unseres heutigen Tests schneller als der MX 4XX, aber gleichzeitig etwas schlechter als der FX-5200 . Allerdings gab es in diesem Teil des Grafikbeschleunigermarktes keinen grundsätzlichen Vorteil zu Gunsten von irgendjemandem in Bezug auf Geschwindigkeit und Leistung. Die Wahl basierte weitgehend auf den persönlichen Vorlieben der Benutzer und den Kosten des Beschleunigers.

- Grafikbeschleuniger der Mittelklasse. Folgende Grafikkarten gehörten im Jahr 2004 zu dieser Kategorie: von Nvidia – FX-5700 und FX-5600, von ATI – Radeon 9600 und Radeon. Der Gesamtvorteil lag in diesem Fall bereits auf Seiten des Herstellers ATI. Rechenleistung Der Radeon 9600-Grafikadapter kam dem damaligen Flaggschiff von Nvidia, der GeForceFX-5900-Grafikkarte, fast nahe.

- Die produktivsten diskreten Grafikbeschleuniger. Diese Nische wurde von der bereits erwähnten FX-5900 und der Radeon 9800-Grafikkarte von ATI besetzt. Letzteres Gerät zeigte damals eine herausragende Leistung. Dadurch war es möglich, nahezu jedes Problem zu lösen.

So wurde der Grafikkartenmarkt im Jahr 2004 aufgeteilt.

ATI Radeon 9200: technische Spezifikationen

Bedeckt mit diese Rezension Der Videoprozessor hatte folgende Eigenschaften:

— Codebezeichnung RV-25;

- Produktionstechnologie Halbleiterkristall– 150 nm;

— Betriebsfrequenz des Videochips – 250 MHz;

— 4 Pixel-Pipelines mit jeweils 1 TMU-Einheit;

— drei Steckplätze für die Installation der AGP-Version 8X.

Es gab auch eine fortgeschrittenere Modifikation dieses Grafikadapters – Radeon 9200 Pro. Der Hauptunterschied zwischen diesen Geräten bestand darin, dass im zweiten Fall die Grafikchipfrequenzen auf 275 MHz erhöht wurden. Der RAM arbeitete in diesem Fall mit 500 MHz, während dieser Wert bei einem herkömmlichen Beschleuniger bei 400 MHz lag. Außerdem wurde ein Videochip für einen Laptop mit identischen Eigenschaften veröffentlicht.

ATI Radeon 9200: Videospeicher

Der ATI Radeon 9200 Grafikadapter wurde mit einem Bus ausgestattet Arbeitsspeicher 128 Bit. In diesem Fall wurde ein Videopuffer vom Typ DDR mit einer Betriebsfrequenz von 400 MHz verwendet. Die RAM-Kapazität dieses Beschleunigers kann 64, 128 oder 256 MB betragen. Im letzteren Fall stieg das Leistungsniveau deutlich an, allerdings waren die Kosten für solche Beschleuniger deutlich höher. Daher waren solche Geräte nicht sehr häufig anzutreffen.

ATI Radeon 9200: Kühlsystem

Wie bereits erwähnt, grafische Lösung ATI Radeon 9200 ist ein Mittelklasseprodukt. Mit einem beeindruckenden Wärmepaket kann das Gerät nicht aufwarten. Daher waren solche Beschleuniger häufig mit einem passiven Kühlsystem ausgestattet, das nur aus einem kompakten Kühler bestand. Häufig wurden auch aktive Kühlsysteme gefunden, die kleine Kühler verwendeten. Im ersten Fall wurde empfohlen, das Gaspedal nur im Nennbetriebsmodus zu verwenden. Im zweiten Fall war eine Übertaktung möglich. Es gab eine ähnliche Version des Videochips für einen Laptop, der mit einem aktiven Kühlsystem ausgestattet war.

ATI Radeon 9200: Analoga zum Zeitpunkt der Geräteveröffentlichung

Wie bereits erwähnt, konkurrierte die ATI Radeon 9200-Grafikkarte zuvor mit zwei Produktfamilien von Nvidia. Dabei handelte es sich um die Modelle GeForceFX-5200 und MX 4XX. Das zweite Gerät erschien deutlich früher als der Held des heutigen Tests und war zudem leistungsmäßig seinem direkten Konkurrenten aus dem Lager des ATI-Herstellers deutlich unterlegen. Beim Einsatz der GeForceFX-5200 konnte in einigen Anwendungen eine leichte Leistungssteigerung erreicht werden. In den meisten Programmen herrschte Parität.